网站首页被k后如何恢复权重 | 降权的原因分析和解决办法

搜寻【玉满斋】的品牌词“玉满斋”浮现连首页都没有了,放心呀!

本来以为是百度算法调解的长久性问题,起头的时分1直没有重视,半个多月都过去了问题依然没有好转的迹象。这时候,我才感触应该是出问题了,于是顿时起头着抄本身排盘查题了,通过几天的阐发后创举首假设出现了1下几点问题:

1、歹意镜像众多紧急。

2、因疏忽删除了robots.txt,而主题已经不反对“www.主域名.com/page/”的链接模式,收录了1少量“www.主域名.com/page/”的无效链接,这些链接但凡指向“www.主域名.com”的。

3、主机因为配置欠妥形成顽固性下降,屡屡宕机,百度站长平台收录抓取报错屡次。

创举问题就顿时起头采取应对顺序:

至今创举的歹意镜像和跳转的域名,好恶心呀!

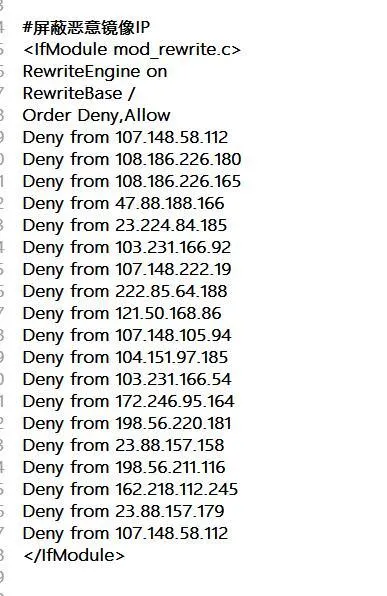

歹意镜像的处置惩罚

歹意镜像迩来众多成灾,创举很多博客都遇到这个问题,极端是在百度的搜寻结果里特其它多,google里这种问题确实没有,看来百度在这方面的技艺有待前进呀,至于这种歹意镜像实现原理据说是“反向 *** ”实现的,成本很是的低,预防顺序网上倒是良多,但通过我近1周的测试,有用的很少很少,收尾就找到1个踊跃跳转会指定域名代码有点成绩以及1个通过果断UA动静来防止歹意镜像的代码。通过近十天的行使感触也是治标不治本的设施,没有体例了只能采用最笨的设施,那即是向百度反馈和揭发了。

其它除了揭发和反馈外,还通过在百度里搜寻网站首页题目大约在结果里找到歹意镜像的网址域名并记实下去,通过ping剖析失掉IP,通过.htacess 来樊篱这个IP,这个义务要屡屡性的去做,积少成多的大约有用的中止歹意镜像的。

百度站长平台里的反馈

百度搜寻结果的“揭发”

用了1周光阴收罗图片截图证据后别离揭发和反馈,有些已经复兴并告之已处置惩罚,有些还在期待结果中,可是百度搜寻结果里的歹意镜像已经承减缓趋势了。

用到的代码下列(下列代码但凡增加到主题的Function.php里的,):

通过UA动静防止镜像

if(!is_admin()) { add_action("init", "deny_mirrored_request", 0);}function deny_mirrored_request(){ //获取UA动静$ua=$_SERVER["HTTP_USER_AGENT"];//将歹意USER_AGENT存入数组$now_ua=array("PHP","FeedDemon ","BOT/0.1 (BOT for JCE)","CrawlDaddy ","Java","Feedly","UniversalFeedParser","ApacheBench","Swiftbot","ZmEu","Indy Library","oBot","jaunty","YandexBot","AhrefsBot","MJ12bot","WinHttp","EasouSpider","HttpClient","Microsoft URL Control","YYSpider","jaunty","Python-urllib","lightDeckReports Bot");//制止空USER_AGENT,dedecms等主流收罗顺序但凡空USER_AGENT,部门sql注入工具也是空USER_AGENTif(!$ua) {header("Content-type: text/html; charset=utf-8");wp_die("严谨警告:请勿收罗本站,因为收罗的站长木有小JJ!");}else{ foreach($now_ua as $value )//果断能否是数组中存在的UA if(eregi($value,$ua)) { header("Content-type: text/html; charset=utf-8"); wp_die("严谨警告:请勿收罗本站,因为收罗的站长木有小JJ!"); }}}

非主域名的接见访问踊跃跳转至指定域名

(注:记得要将代码内的“主域名”批改为本身的域名哦)

add_action("wp_footer","deny_mirrored_网站sites");function deny_mirrored_网站sites(){ $currentDomain="www." + "主域名." + "com"; echo "";}

总结阐发:

今朝看来,揭发反馈仍是有成绩的,两个代码也起到了1些作用,究竟歹意镜像是为了借助镜像网站的流量来到达不行告人的目的的,直接跳转回指定域名对其反制仍是“有的放矢”的。

robots.txt的启用

因为疏忽删除了robots.txt,当初看来这是1个不行海涵的疏忽呀!在robots.txt加之“Disallow: /page/”制止搜寻引擎抓取,并且在百度站长平台里提交“www.主域名.com/page/”死链交往来往除搜寻结果里的这些无用链接,通过3-5天后搜寻结果里没有这些死链了。

总结阐发:

robots.txt文档仍是很是紧迫的,绝对是不能没有的,极端是国外网站,因为百度本身技艺的不行熟对于链接的阐发和辨析本事仍是托付家养的多1些,所以robots.txt1定要用好了,并且robots.txt的要随着网站的连接布局调解而中止响应的配置,这次首页品牌词权重的消散估计跟robots.txt有很大的干系,失效的“www.主域名.com/page/”应该是分化了首页链接的权重的。

主机的顽固性很关键

顽固主机根本上是个网站优化里陈词难听的话的问题了,可是对于1个喜爱折腾的草根站长来说,无意候真的是“No do!No die!”呀,不折腾就不会有那么多的问题,前1阵子为了好玩在侧边栏里参预了“百度打赏”的组件,没有想到形成了评论链接1直报“连接超时”的提示框,废了很大的光阴才找到是“百度打赏”的1段代码链接死链形成的。又因为折腾缓存插件缓存了全站的 *** 文档,形成网站评论提交后出现“404页面”都半个多月了才创举,囧呀!

总结阐发:

能不瞎折腾就不瞎折腾,要折腾也尽量在外地后行测试好了在折腾,有些怪异的妨碍但凡“折腾”形成的。

通过上述的这些调解后,究竟就在前天我的品牌词权重复原了,首页也归来了,扫数掉落的都归来了,唉!累死我了都!想想但凡本身作的呀!

博客